반응형

https://arxiv.org/pdf/2410.06158

✅ GR-2

인간 언어 설명을 입력으로 받아, 시각 관찰과 로봇 상태를 기반으로 직접 행동 궤적을 출력하는 언어-조건 기반 GPT 스타일 모델

- 대규모 동영상 사전학습 (Video Generative Pre-training):

- 3,800만 개의 인터넷 동영상 클립, 총 500억 개 이상의 토큰으로 구성된 방대한 데이터셋으로 사전학습을 수행.

- 다양한 인간 활동 데이터를 포함하며, HowTo100M, Ego4D, Something-Something V2, EPIC-KITCHENS, Kinetics-700 등에서 수집한 영상이 활용.

- 로봇 데이터 파인튜닝 (Robot Trajectory Fine-tuning):

- 사전학습된 모델에 로봇 궤적 데이터를 이용해 행동 예측 및 비디오 생성을 동시에 학습.

- 이 과정을 통해 실질적인 조작 성공률이 향상.

- 새로운 배경, 환경, 물체, 작업 등 이전에 학습하지 않은 상황에서도 뛰어난 일반화 성능

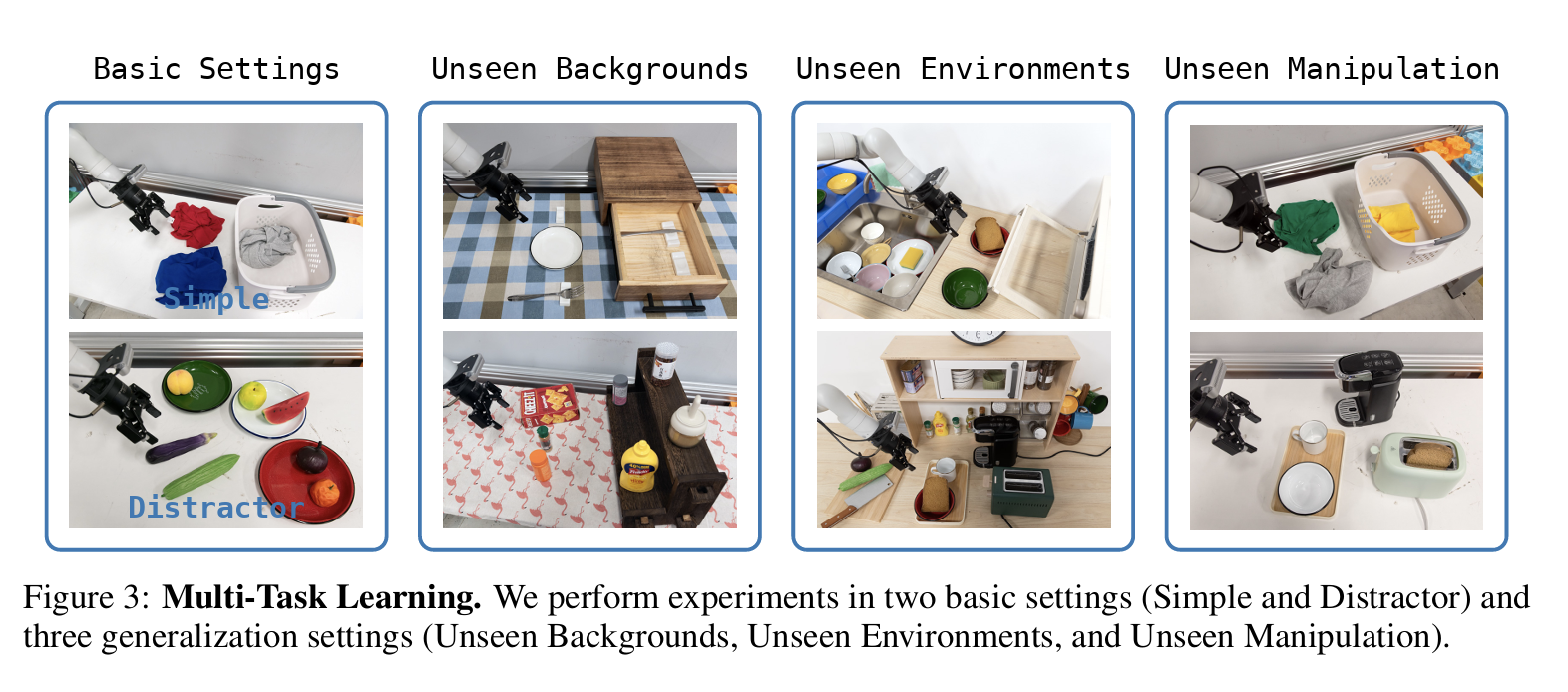

✅ Unseen generalization settings (Multi-task learning)

- multi-task learning, end-to-end bin picking 두 종류의 실험을 진행 (Multi-task learning: OOD 성능)

- 8개의 skill이 담긴 100개의 task를 수행

✅ Real-World Multi-Task Learning

GT collect 방식

사람 연구자가 teleoperation (원격 조작 장치)으로 로봇 팔을 직접 조작해서 데모 데이터를 모음. (게임기 조이스틱이나 VR 컨트롤러 같은 장치를 잡고 원격으로 로봇을 조종)

- 사람이 teleoperation으로 로봇 팔을 조종해서 작업(컵 집기, 뚜껑 열기 등)을 수행.

- 이때 로봇 카메라 영상 + 로봇 상태(관절 각도 등) + 사람이 내린 제어 신호가 모두 기록됨.

- 결과적으로, “주어진 상황(영상) → 사람이 조작한 행동 궤적(trajectory)” 쌍이 데이터셋이 됨.

- 이게 바로 Ground Truth (GT) supervision 역할을 함.

Training

- GR-2는 사전학습된 비디오-언어 모델 위에, 수집한 시연 trajectory 데이터를 파인튜닝해서

→ “영상 + 언어 지시 → 올바른 로봇 행동”을 예측하도록 학습함. - Generalization performance 향상을 위해 새로운 object를 scene에 추가하거나, background를 바꾸는 등의 data augmentation을 fine-tuning 시에 진행 (w/ DA setup)

- 새로운 object 삽입: diffusion 모델로 특정 위치에 새로운 물체 합성.

- 배경 교체: SAM으로 배경 분리 → 다른 배경으로 바꿔치기.

- 자연스러운 동영상 보정: video generation 모델로 inpainting 결과와 원본 로봇 motion을 합쳐서 "진짜 같은 augmented video" 생성.

Evaluation

- 학습이 끝난 뒤에는 사람이 로봇을 조종하지 않음

- 대신, 모델이 주어진 언어 명령(예: “컵을 들어 올려”)과 카메라 영상을 입력받고, 스스로 다음에 취해야 할 로봇 액션 시퀀스(trajectory)를 생성 (Inference)

- 이 trajectory를 실제 로봇에 실행시켜서 성공/실패를 측정.

- Unseen Backgrounds / Unseen Environments / Unseen Manipulation에서 성능을 측정

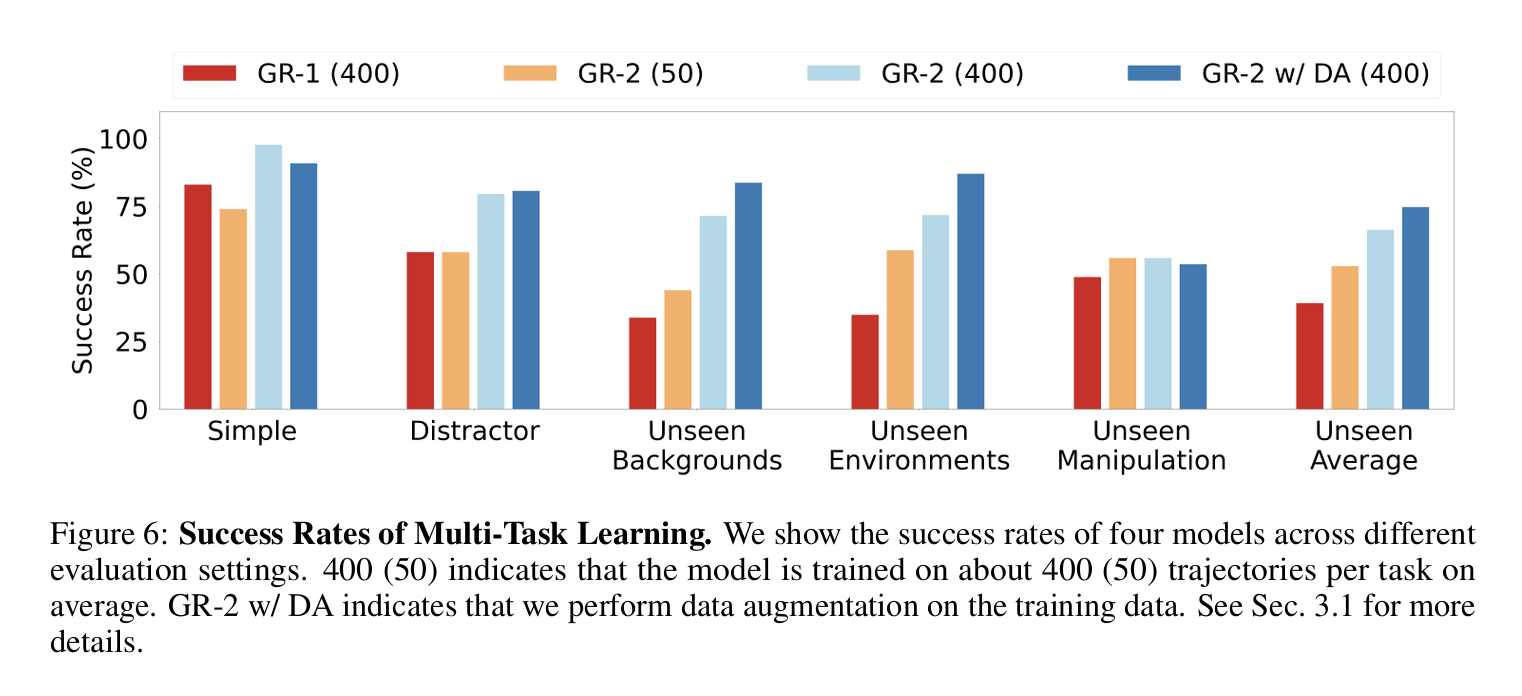

Experiment Results

- Basic

- Simple: 훈련 데이터와 유사한 환경.

- Distractor: 장면에 방해 요소 추가 (비슷한 색/형태 물체 → 혼동 + 충돌 회피 필요).

- Simple: 97.7% 성공률 → 강력한 멀티태스크 학습 능력.

- Distractor: 방해물 있어도 target 객체에 집중 가능.

- Generalization performance

- Unseen Backgrounds: 새로운 테이블보 배경 2종.

- Unseen Environments: 전혀 다른 2개 주방 환경, 배경 + 환경 관련 distractor 포함.

- Unseen Manipulation: 훈련에 없던 물체/카테고리 조작 (완전히 새로운 물체, 새로운 명령). → 가장 난이도 높음.

- GR-1 대비 모든 세팅에서 성능 향상.

- Unseen Backgrounds: 71.4% (GR-1 대비 2배).

- Unseen Environments: 71.7%, 데이터 증강 적용 시 **87.0%**까지 상승.

- Unseen Manipulation: 55.8%, 가장 어려움.

- 실패 사례:

- 새로운 형태의 물체를 집기 실패.

- unseen 객체 지시 시 잘못된 물체를 선택.

- 실패 사례:

반응형

'RL 🤖' 카테고리의 다른 글

| [Robot] GR-1: Video generation을 robot manipulation에 활용하기 (1) | 2025.09.09 |

|---|---|

| [Robot] Point trajectory를 이용한 Policy Learning (0) | 2025.09.04 |

| [Daily] Unified Reward Model for Multimodal Understanding and Generation (0) | 2025.03.13 |

![[Robot] GR-2를 보고 정리하는 OOD (Out-Of-Distribution) setting](https://img1.daumcdn.net/thumb/R750x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdna%2FbnZOlf%2FbtsQtFYQnsm%2FAAAAAAAAAAAAAAAAAAAAABNc0kuwVqRzXzlIKgGdV4hNwipxhijtu-vbfuvQjb3h%2Fimg.png%3Fcredential%3DyqXZFxpELC7KVnFOS48ylbz2pIh7yKj8%26expires%3D1767193199%26allow_ip%3D%26allow_referer%3D%26signature%3DqyMdQd%252BpdeJ8voVyKavQaxB5ZeY%253D)